Чтобы понять причины методологического кризиса воспроизводимости в науке, социологи и экологи попытались выяснить, насколько будут сходиться результаты у разных исследователей, получивших одни и те же данные и исследующих одни и те же гипотезы. Оказывается, даже в таких идеальных условиях результаты значительно разнятся и воспроизводимость оставляет желать лучшего. И, по всей видимости, добросовестность и следование протоколу тут (почти) ни при чем.

Современная наука находится в многолетнем кризисе, который называется кризисом воспроизводимости и заключается том, что результаты многих экспериментов затруднительно повторить или воспроизвести. А ведь воспроизводимость экспериментальных исследований — важнейший критерий их принятия научным сообществом. Как быть, если сам критерий поставлен под сомнение?

Впервые о проблемах с воспроизводимостью заговорили психологи. В 2010 году они попытались повторить результаты ста научных работ, опубликованных в 2008 году. Повторить или воспроизвести удалось только 39 из них, и это шокировало психологическое сообщество. Не успев «зародиться» в области психологии, кризис воспроизводимости сразу же вышел за ее пределы: показатели воспроизводимости в биологии рака и разработке лекарственных средств — областях, традиционно считавшихся более «точными», — оказались еще ниже. С тех пор собралась целая «коллекция» из проектов по изучению воспроизводимости, приведших к неутешительным результатам (см. Replication crisis). Большего всего сообщений о невоспроизводимости было из области психологии и медицины, но проблема также зафиксирована в экономике и даже в управлении водными ресурсами!

В метанауке (науке о науке) выдвигались разные гипотезы о причинах кризиса, но до недавнего времени самыми популярными причинами считались недостаточная добросовестность и квалификация исследователя, а также недоступность первичных данных для повторного анализа. Такого подхода придерживается, например, австралийский физик и математик Майкл Барбер. В своей непериодической статье на сайте Международного научного совета он призывает, например, сделать публикацию исходных данных обязательной и использовать более сложные вычислительные методы для оценки воспроизводимости, включая методы на основе искусственного интеллекта (см. M. Barber. Strengthening research integrity: The role and responsibilities of publishing). Он также напоминает об ответственности редакторов и издателей за обеспечение воспроизводимости — впрочем, как и об ответственности самих исследователей. Однако действительно ли проблемы воспроизводимости происходят только от недобросовестности и отсутствия квалификации?

Недавно с разницей в год были опубликованы результаты двух методологически сходных метаисследований воспроизводимости в науке — при этом воспроизводимость проверялась в совершенно разных областях. Вместо того чтобы пытаться повторить результаты опубликованных ранее исследований, авторы метаисследований привлекли коллег-ученых в качестве испытуемых, предложив им готовые гипотезы для проверки и наборы данных. Задачей исследователей было только построение статистических моделей и формулирование выводов на основе статистики.

Результаты первого метаисследования были опубликованы в PNAS в октябре 2022 года (N. Breznau et al., 2022. Observing many researchers using the same data and hypothesis reveals a hidden universe of uncertainty). В этом исследовании проверялась одна гипотеза из области социологии — о снижении поддержки социальной политики в обществе под влиянием иммиграции. В исследовании участвовали 73 исследовательских группы (всего — 161 человек). У всех исследователей был один и тот же большой набор данных из Международной программы социальных исследований (см. International Social Survey Programme).

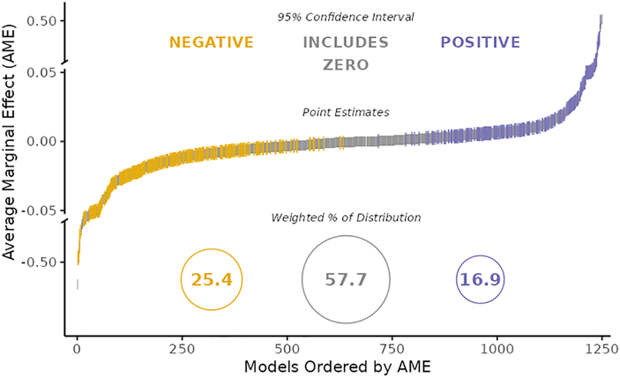

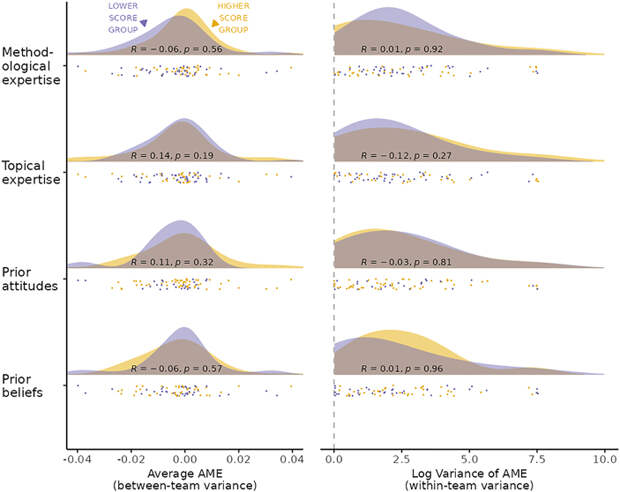

13,5% исследовательских групп сочли гипотезу непроверяемой на основе имеющихся у них данных, 60,7% отклонили ее, а 28,5% сочли подтвержденной. Сходный разброс наблюдался и при оценке только статистических результатов, без субъективных выводов (рис. 2). И, что еще более интересно, руководители проекта не нашли никаких корреляций между опытом и специализацией исследователя, его установками и убеждениями (рис. 3). Различия в дизайне исследования объясняли только 2,6% расхождений, а различия в характеристиках исследователей — только 1,2%. 95,2% разброса результатов остались необъяснимыми.

В октябре 2023 года на EcoEvoRxiv появился препринт сходного метаисследования в области экологии (см. E. Gould et al., 2023. Same data, different analysts: variation in effect sizes due to analytical decisions in ecology and evolutionary biology). Около 400 исследователей оценивали две экологические гипотезы:

1. Рост птенцов обыкновенной лазоревки зависит от конкуренции со стороны братьев и сестер в гнезде.

2. Количество молодых деревьев эвкалипта зависит от травяного покрова.

Участникам также предоставлялись одни и те же наборы данных — из еще не опубликованных работ.

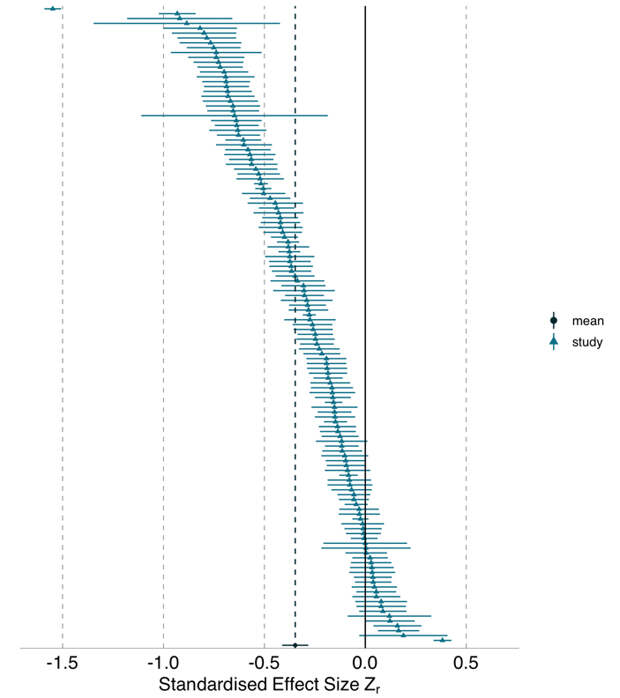

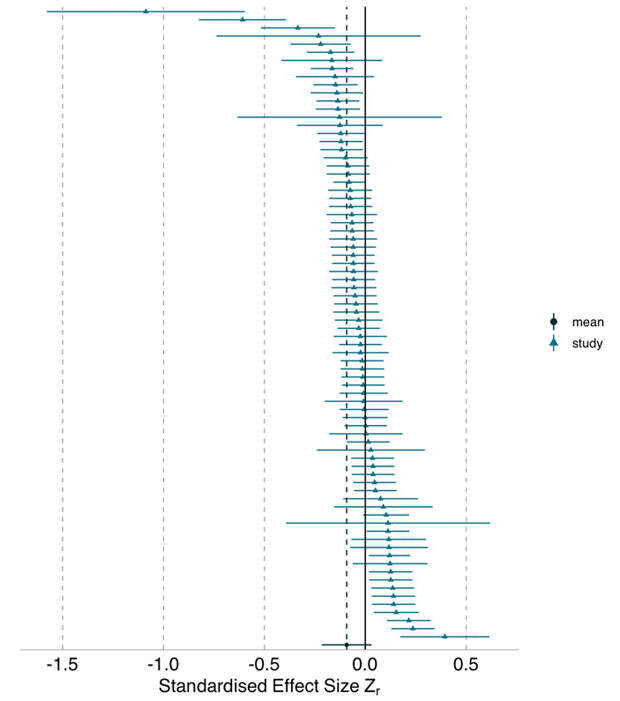

В случае первой гипотезы большинство исследователей хотя бы согласилось, что наличие конкурирующих за пищу братьев и сестер негативно влияет на рост птенцов лазоревки, но вот оценки степени этого влияния существенно разнились. Во втором случае большинство исследователей обнаружили лишь слабое влияние травы на проростки эквалипта, но несколько групп получили экстремальные результаты: обнаружили, что травяной покров сильно мешает эвкалипту прорастать — или наоборот, стимулирует его к этому.

В экологическом метаисследовании не было такого подробного анализа опыта и установок участников как в социологическом метаисследовании. Однако участники-исследователи проверяли друг друга, имитируя процесс рецензирования. Некоторые, самые крайние, результаты таким образом удалось отсечь, но даже после рецензирования результаты разных участников всё еще сильно разнились.

В обоих метаисследованиях две большие группы ученых значительно разошлись в ответах на поставленные вопросы, работая на одних и тех же данных. При этом их добросовестность и квалификация, похоже, почти не влияла на результаты, и даже рецензирование не сильно помогало.

В статье в PNAS руководящие исследователи констатируют, что, по всей видимости, вариация получаемых результатов связана с какими-то внутренними факторами, которые невозможно легко выявить и исключить. Популяризатор доказательной медицины Петр Талантов комментирует эту ситуацию так: «Когда обсуждаются проблемы воспроизводимости научных результатов, предполагается, что одна из основных причин — в систематических искажениях (байасе). Предотвратим систематическое искажение — получим правильный ответ. Иногда как причина звучит недостаточная квалификация исследователей — мол, неправильно проанализировали данные, если проанализируем правильно, то ответ будет верный. Но похоже на то, что предотвращение байаса само по себе не гарантирует воспроизводимость. И квалификация исследователей тоже, так как не существует единственного безусловно верного методологического решения, которое знает и с точностью повторит любой достаточно грамотный специалист».

Выход из этой ситуации найти довольно сложно. Авторы препринта на EcoEvoRxiv предлагают для повышения надежности использовать метод множественных анализов рутинно, предлагая одни и те же данные разным группам и затем усредняя их результаты. Аналогичным образом Петр Талантов завершает свой комментарий: «Доживем ли до тотально открытых данных и нового вида метаанализов — синтеза результатов неоднократного анализа данных разными независимыми исследователями?»

С кризисом воспроизводимости наука, скорее всего, справится — но он может сильно изменить ее облик.

Источники:

1) Nate Breznau, Eike Mark Rinke, Alexander Wuttke, and Tomasz Zoltak. Observing many researchers using the same data and hypothesis reveals a hidden universe of uncertainty // PNAS. October 28, 2022. V. 119 (44). P. e2203150119. https://doi.org/10.1073/pnas.2203150119.

2) Elliot Gould et al. Same data, different analysts: variation in effect sizes due to analytical decisions in ecology and evolutionary biology // EcoEvoRxiv. Published: 2023-10-04.

3) Anil Oza. Reproducibility trial: 246 biologists get different results from same data sets // 12 October 2023. Синопсис этой статьи в Nature.

Георгий Куракин

Свежие комментарии